Ühel päeval rääkis Peeter Marvet mulle niisugust asja, et mõnede riigiasutuste kodulehekülgede indekseerimine on otsingurobotitele keelatud. Idee niisuguse asja taga olevat see, et inimene külastagu ise lehte ja mitte ärgu kasutagu Neti või Google otsingut.

Ühel päeval rääkis Peeter Marvet mulle niisugust asja, et mõnede riigiasutuste kodulehekülgede indekseerimine on otsingurobotitele keelatud. Idee niisuguse asja taga olevat see, et inimene külastagu ise lehte ja mitte ärgu kasutagu Neti või Google otsingut.

Minule tundus niisugune asi uskumatuna ja väga jaburana. Me teeme endale kodulehe ja ei taha et külastajad sinna otsingumootori kaudu tuleksid? Miks?

Tegin siis väikese kontrolli, et kuidas Eesti riigiasutuste lehtedel selle asjaga lood on, kas otsinguroboteid piiratakse ning mida sisaldab robots.txt. Tulemused ei olegi kõige hullemad ehki robots.txt protokolli valdavalt ei kasutata:

| Asutus | Pagerank | Favicon | robots.txt |

| President | 7 | ei | Puudub, suunatakse esilehele ümber |

| Riigikogu | 8 | jah | Paarile robotile on kõik keelatud |

| Riigiportaal | - | jah | Puudub, suunatakse esilehele ümber |

| Kaitsevägi | 7 | jah | Puudub |

| Valitsus | 7 | ei | Puudub |

| Riigikantselei | 7 | jah | Puudub, suunatakse mingile katkisele lehele ümber |

| Riigiteataja | - | ei | Kõigile robotitele on kogu sisu indekseerimine keelatud |

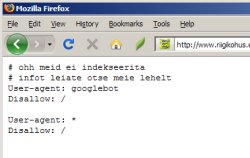

| Riigikohus | 7 | jah | Kõigile robotitele on kogu sisu indekseerimine keelatud. Failis märkus "# ohh meid ei indekseerita # infot leiate otse meie lehelt". |

| Osalusveeb | - | jah | Puudub, suunatakse vealehele ümber |

| Eesti Pank | 7 | ei | Määratud vaid "crawl delay" |

| Riigikontroll | 7 | ei | Ühele kataloogile on kõikidel robotitele juurdepääs keelatud |

| Finantsinspektsioon | 6 | ei | Puudub |

| Õiguskantsler | 7 | ei | Puudub |

| Kohtud | 6 | jah | Kõigile robotitele on kohtulahendite indekseerimine keelatud |

| Prokuratuur | 6 | jah | Puudub, suunatakse esilehele ümber |

| Politsei | 8 | ei | Puudub |

| Haridus- ja Teadusministeerium | 8 | ei | Puudub |

| Justiitsministeerium | 8 | jah | Puudub |

| Kaitseministeerium | 7 | jah | Paarile kataloogile on kõikidel robotitele juurdepääs keelatud |

| Keskkonnaministeerium | 7 | jah | Puudub |

| Kultuuriministeerium | 8 | ei | Puudub |

| Majandus- ja kommunikatsiooniministeerium | 7 | ei | Puudub, suunatakse mingile katkisele lehele ümber |

| Põllumajandusministeerium | 7 | jah | Paarile kataloogile on kõikidel robotitele juurdepääs keelatud, olemas viide sitemap.xml failile |

| Rahandusministeerium | 7 | ei | Paarile kataloogile on kõikidel robotitele juurdepääs keelatud |

| Siseministeerium | 6 | jah | Paarile kataloogile on kõikidel robotitele juurdepääs keelatud |

| Sotsiaalministeerium | 7 | jah | Puudub |

| Välisministeerium | 8 | jah | Paarile kataloogile on kõikidel robotitele juurdepääs keelatud |

Päris ära on oma saidi indekseerimise keelanud vaid Riigikohus ja Riigiteataja.

Ma ei viitsi standardist otsida, aga ma arvan, et robots.txt ümbersuunamine mingile lehele ei ole sellega küll kooskõlas. Parem oleks siis juba viisakalt 404 veateade väljastada.

Au ja kuulsus Põllumajandusministeeriumile, kes ainsana oma robots.txt failis ka XML formaadis sisukaardile viitab.

* * *

Google pageranki aitas leida Pagerank Status Extension.

Asja köögipoolelt leiab “Disallow *” puhul mõnikord selliseid dialooge:

“isver-susver, klient kaebab, et meie uus veebisüsteem kannatab jõudlusprobleemide käes. Aeglane nagu tatt!”

“Jah, vaatasin andmebaasist ja veebiserverist, meil on väga palju päringuid. Aga näe, palju päringuid on tegelikult mingid robotid”

“Oh issand, ega me nende jaoks seda süsteemi ei ehitanud. Dokumentatsioon näeb kasutajatena ette ametnikud ja kodanikud. Lahendame probleemi robotite keelamisega”

robots.txt kaudu keelatakse “andmebaasimahukad” lehed maha (teadupärast on enamus veebilehti sisuliselt andmebaasi frontendid), serverite load normaliseerub, probleem lahendet.

Seda saab ju robots.txt kaudu määrata, et kui tihedalt robotid päringuid teha võivad… Seda tean isegi mina, kes ma pole mingi eriline webmaster.

Siit tekib veel küsimus, et miks tellivad riigiasutused oma veebilehed mingite amatööride käest, kes ei suuda päringuid optimeerida ja selle asemel hoopis robotite ligipääsu keelavad?

Avalikud lehed, mille laadimisel kohe tehakse koormav päring on nii või teisiti potentsiaalsed probleemiallikad. Mis siis, kui crawleri asemel nt mõni vend ise naljaviluks lihtsa taaslaadiva skripti sellele kallale laseb? Ma mäletan kord üht juhtumit, kus üks murelik kodanik kirjutas skripti kontrollimaks, kas üks teatud veebileht on üleval ja kättesaadav. Plaan oli hea, aga ülitihe avalehe pärimine tekitas mõttetut liiklust. Samas kavatsused olid tal head ju…

Nii palju siis palju kiidetud e-riigist…

Su nimekirjast puudub Andmekaitse inspektsioon, kes blokeerib hulga üksikuid lehekülgi, sealhulgas andmekaitsjate endi kontakti- ja haridusandmed. Järsku peaks selle asutuse Enesekaitseametiks ümber nimetama?

Nüüd ma vist saan linkimise eest menetluse kaela.

Tundub, et aki.ee puhul on lihtsalt saidi struktuuri ja aadressi muudetud. Nende uud aadress on http://www.dp.gov.ee. Kontaktandmed ja haridused on nähtaval blokeerimata lehekülgedel.

@larko – kusjuures nüüd on aki robotites hoopis viide sitemap’ile, mis on ju lausa progressiivne (Saurus muideks vastas kunagi mu ülekutsele ning tegi tasuta sitemap’i-mootori, kõigil Saurust pruukivatel riigiveebidel seega vaid installimise vaev)

@aarne – tegelikult on aki.ee uus ja dp.gov vana; rääkisin nende vanast kõike keelavast robots.txt’ist nii endise kui praeguse peadirektoriga ning kutsusin uue suhtejuhi oma vikid-ajaveebid-jne kursale, loodetavasti saab neist asja; rääkisime nendega ka sellest, et peaks tegema miski üldise soovituse, et mida keelata – neid isikunimesid lekkivaid saite on palju, samas tekitaks keelamine olukorra kus standardit mitte austavad nuhid omavad rohkem infot kui näiteks isik ise, kes ei leia Google’i abil üles seda enda kohta käivat infot mida nt ÄP ajakirjanik võiks korporatiivse otsinguga omada… vaja arutada

Rahaminis on mõned URLid tõesti blokeeritud ja taotluslikult (hetkel mitteaktiivsed veebiosad). Natuke aega tagasi oli kõik disallow, Martini kirjeldatud põhjusel muideks (alternatiivne selgitus on muideks spämmi vähendamine).

Riigikohus tegeleb asjaga, loodetavasti saab lähipäevil korda.

Lisaks Aarne viidatutele on keelav robots ka (neti.ee Kain Kalju tegi kiire grepi oma robots.txt cachele ükspäev, tänud):

http://www.kapo.ee

http://www.kra.ee

http://www.konkurentsiamet.ee

http://www.rha.gov.ee

http://www.teabeamet.ee

http://www.riigikohus.ee

http://www.tarturk.just.ee

rvr.fin.ee

register.fin.ee

(rahamini registrid on niikuinii sisselogimisega, tahetakse et kodaniku sattuksid kirjeldavale lehele; rahamini allasutustega rahamini IT loodetavasti juba tegeleb; justminile on läinud kiri; aasta lõpus oli mäletamist mööda ka EAS, aga vist jõudis miski kaudselt lähetatud vihje kohale; kapo ja teabeameti puhul on nähtavasti loomupärane ent õigustamatu turva-paranoia; kra võiks rohkem mõelda kuidas poisse väeteenistusse võtta ja vähem otsimootoritega luurekat mängida, eks ma pingin kamina kontakte kah…)

Tegelikult pole alati kõik nii must-valge. Põhjusi miks ühel või teisel juhul on nii või teisiti toimitud võib olla mitmeid. Kuid alati saab seljuhul asjaosaliste endi käest ise küsida. Kahjuks valis Peeter selleks kõige pikema tee – nimelt justiitsministri. Kuigi riigikohus pole justiitsministeeriumi haldusalas, vaid on eraldiseisev põhiseaduslik institutsioon. Miks kommunikatsioon seda rada läks eks teab tema ise (justiitsminister > riigikohtu esimees > riigikohtu direktor > IT osak). Miks aga sai juba aastaid (pakun, et 5 aastat) tagasi riigikohtu kodulehe indekseerimise keeld pandud on hoopis teised asja olud, kui nii Peeter kui blogi autor Aarne põhjustena välja on toonud. Kus juures ma pole seda kunagi isegi nii mõelnud, et see aitab spämmi tõrjuda või jõudluse puudumisest ülesaada. Selleks kaitseks on teised vahendid ja meetodid. Peamine põhjus peitub infos mida rk koduleht sisaldab. Need on kohutlahendid, mis on arusaadavalt rk põhitegevuseks. Nendes (sel ajal pea kõigis) lahendites aga sisaldusid nimed. Ja nii võis sattuda isiku nimi ja rk lahend ostimootoreisse esimese vastena. Isegi kui inimene pole süüditunnistatud, on tahtmatult kaasatud kohtuteele või on juba oma karistuse kandnud on see seal ikkagi olemas. Ka ei pruugi tavainimene, kes sellise juriidilise jutu otsa satub sellest isegi õigesti aru saada. See aga võib hakkata mõjutama kodaniku edasist elukäiku. Ta võib isegi kaotada töökoha.

Tegelikult oli ka reaalselt kogu selle asja taga konkreetne juhtum. Praegune õigusruum on küll tollasest erinev, sest on olems nii avalikuteabe seadus kui ka isikuandmekaitse seadus. Minu ja mitte ainult minu seisukohalt on need aga üsna vastuolulised. Näiteks http://74.125.77.132/search?q=cache:NSQPiiLnBSYJ:eky.just.ee/failid/Kohtud%2520ja%2520ajakirjandus%252016.10.2007.ppt+andmekaitseseadus&hl=et&ct=clnk&cd=3&gl=ee

Aastaid tagasi, kui see robots.txt sai tekitatud, sisaldas see “ohh” seda olgem ausad emotsiooni, mis oli seotud selle otsimootorite ja lahendidte leidmise jandi ümber. Ei leidunud juristi, kes oleks öelnud kuidas toimida. Olin isegi kurb, et rk kodulehe ajalugu ja areng ei salvestu internetis ( wayback machine ). Vaidlesin siis ka ise, et üsna raske ja pea võimatu on keelata indekseerimist kasvõi nende jaoks, kes ei mängi kokulepete järgi. Nüüd ja täna tõlgendatakse seda aga ristivastupidiselt. Eks tollane lähenemine põhines paljuski tolle hetke teadmistel oskustel ja tuginedes vana kodulehe ülesehitusel. Uue kodulehe valmistajad selle tehnilise nüansi võtsid lihtsalt kaasa. Küll on minu arvamus, et see robots.txt asi on teemapüstitajate poolt eksitavalt kallutatud, et see mehanism justkui keelaks (rõhk ongi sõnal keelama) kodulehe kättesaadavust. Kirjutage google’see sõna riigikohus – see on seal olemas ja esimeste vastetena. Tahetakse jätta muljet, et robots.txt oleks juskui saatanast. Muideks nii google’l ja ka neti’l on robots.txt (http://www.google.com/robots.txt, . Ka Pets’i enda lehel on see olemas http://tehnokratt.net/robots.txt. Jah see viimane tegelikult lubab kõike. Süntaksi mitte tundev isik aga ei pruugi sellest arusaada ning viite korral näeb ta, et probleem on ju olemas. robots.txt ei ole lukk ukse ees vaid on pigem kui silt muuseumi sisspääsu juures, kus on kirjas, et välguga pildistada pole lubatud.

Lõpetuseks olen nõus sellega, et selle robots.txt süntaksit võiks muuta leebemaks. Aga ma ei taha ka endale jalga tulistada. Veel vähem mõjutada teiste elusid. Aga ma luban, et tegelen teemaga edasi ning leida lahendused, et veel rohkem infot oleks otsimootorite abil leitav.

Argo

@Argo – Tõepoolest, kett sai tiba pikk tingituna sellest, et olen juba mõned kuud teemat torkinud ning omades teatavat kogemust torkimise efektiivsusega eskaleerin pigem üle. Nagu ma aru saan on see robots.txt keelav juba õige mitu aastat ning ega ükski teema iseenesest prioriteetseks ei muutu (ja nüüd ei ole see enam Sinu mure, vaid on igal tasemel teadvustatud avalik huvi mida saab arnedusplaani sisse kirjutada).

See “justnagu keelaks kodulehe kättesaadavust” tuleks aga veidi sügavamalt lahti mõelda, sest eeldus “kasutaja tuleb minu veebi ja otsib siit midagi” oli aktuaalne suurportaalide ajastul (ja kehtis ka siis ainult suurportaalide kohta). Kasutaja ei otsi Riigikohust vaid lahendust mingile probleemile, kusjuures Riigikohtu lahend võib olla üks osa vastusest.

Sisuliselt on meil tegu usability-probleemiga mis tingitud sellest, et IT on valinud nende ees seisvate ülesannete täitmiseks lahenduse mis on ITle mugav ja … who cares kasutaja ning avaliku teabe seaduse mõte?

Seega on vaja – näiteks AKI eestvedamisel – panna kokku avaliku teabe avalikustamise põhimõtted. Sellest tuleneb tehniline spekk praktiliste rakenduse jaoks ja siis on võimalik hakata neid kenasti ümber kirjutama või võtta aluseks vahest hoopis midagi kusagil olemasolevat :-)

Arne:

Rahandusministeeriumi haldusala (sh Statistikaameti) veeb elab Sauruse otsas. Sauruse poolne soovitus oli robot.txt abil veebi indekseerimine kinni keerata (vaidlesin RM adminnidega, miks seda teha ei tohi, üsna pikalt). Kas Sa väidad, et Sauruse tüübid on amatöörid? :)

Argo:

Nii haiget selgitust pole ma veel enne näinud :( Kõik kohtulahendid on avalik informatsioon ning nende indekseerimise keelamine on tegelikult vesi vaikiva ajastu sünnile. Muide mis takistab mind kirjutamast robotit, mis robots.txt faili ignoreerib? Sellised robotid on spämmerite hulgas vägagi levinud.

Samuti, mis takistab mind kogu veebi kõige täega allalaadimast? Muide, 2002 või 2003 aastal pöörduti minu poole (ma töötasin siis AKI-s). Probleem oli selles, et keegi oli kola veebi täiega alla tõmmanud ning sealsetest lahenditest andmebaasi tekitanud (nimi, isikukood, kohtumenetluse aeg, süüdistus, karistus, + veel mõned detailid). Seda andmebaasi müüdi CD-peal personalijuhtidele, hind oli mingi 600 eek tükk.

Mina väidan, et jõudluseprobleemide lahendamine robots.txt abil on vale.

vale jah

Asja sest robotist. Julgeoleku postkast on selline: https://www.teabeamet.ee/